목차

<논문링크>

기존 CNN의 layer를 깊게 쌓는 과정에서 발생하는 Vanishing Gradient(기울기 소실), Overfitting(과적합) 등의 문제를 해결하기 위해 Residual learning framework를 사용해 전보다 깊은 네트워크를 학습 시킬 수 있도록 하였다.

결과적으로 VGG보다 8배 깊은 152개의 layer를 사용하며 앙상블 기법까지 적용해 오차를 3.75% 까지 줄이게 되었고, 이는 처음으로 Human Recognition보다 높은 값이다.

22.08 기준 논문 인용 130,000회.

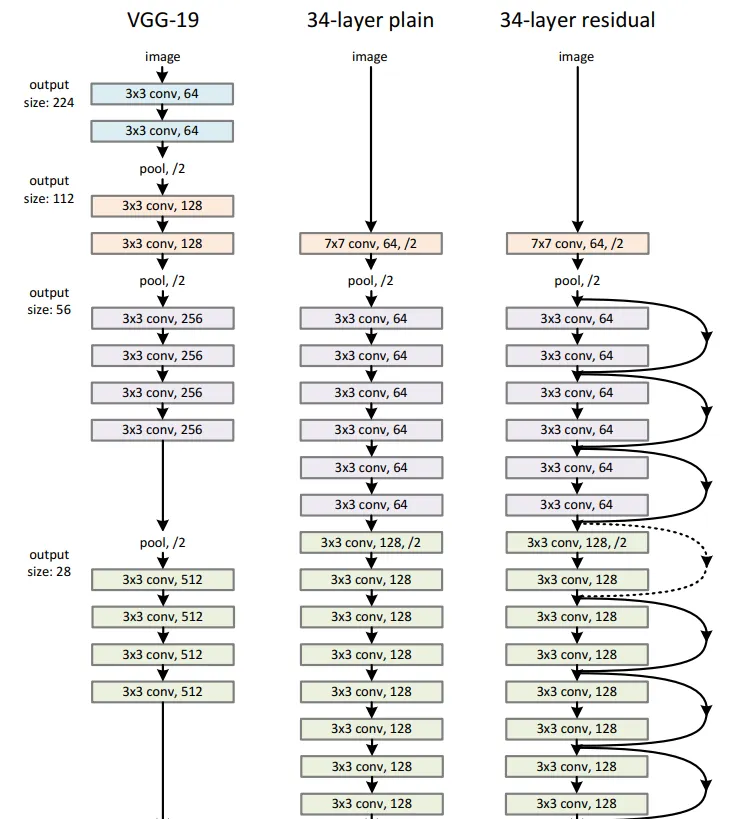

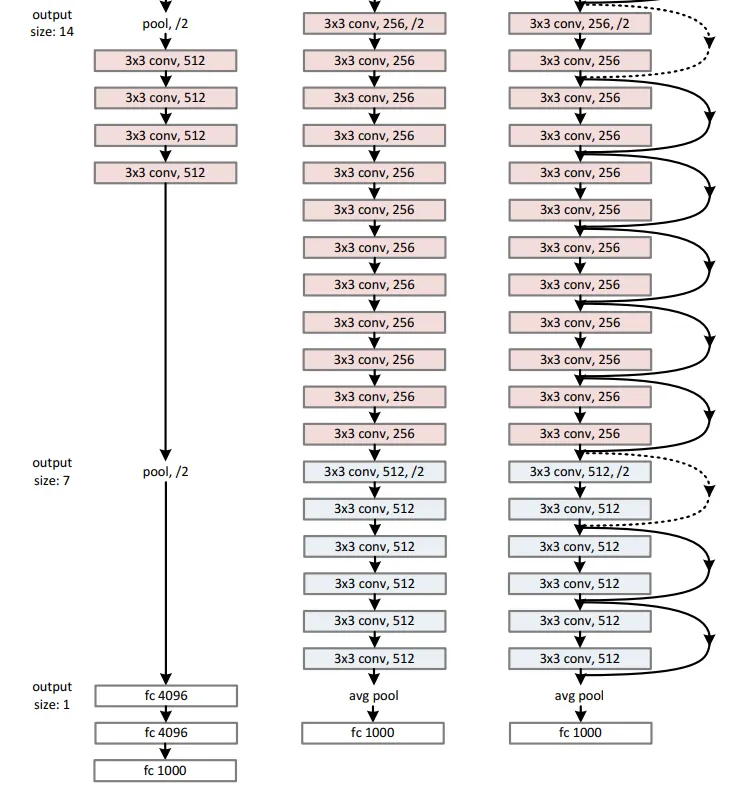

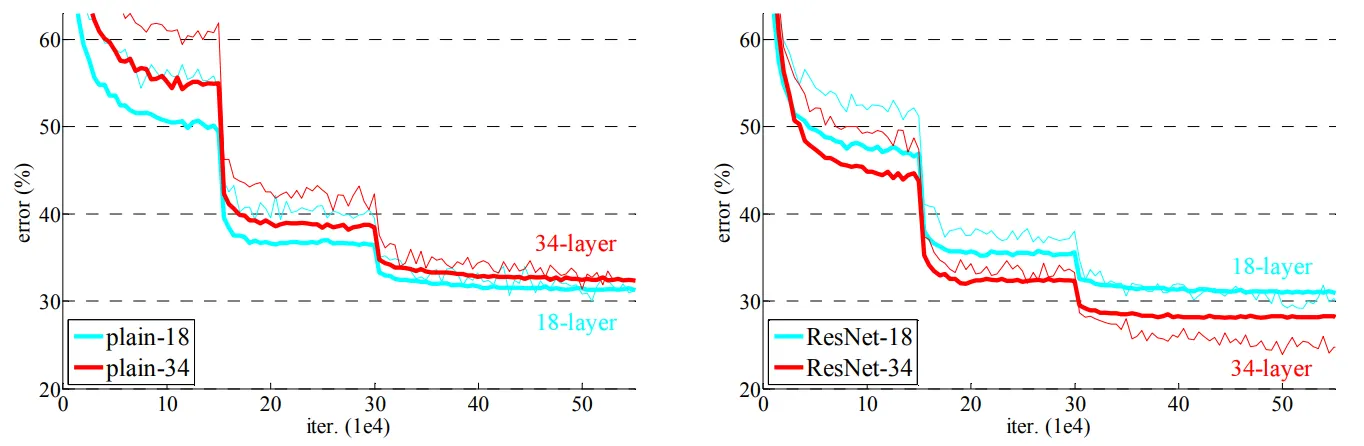

위 사진은 VGG, Plain, ResNet을 비교한 그림이다.

Plain Network는 단순히 Convolution 연산을 쌓기만 한다면, ResNet은 Block 단위로 Parameter를 전달하기 전에 이전의 값을 더하는 방식이다.

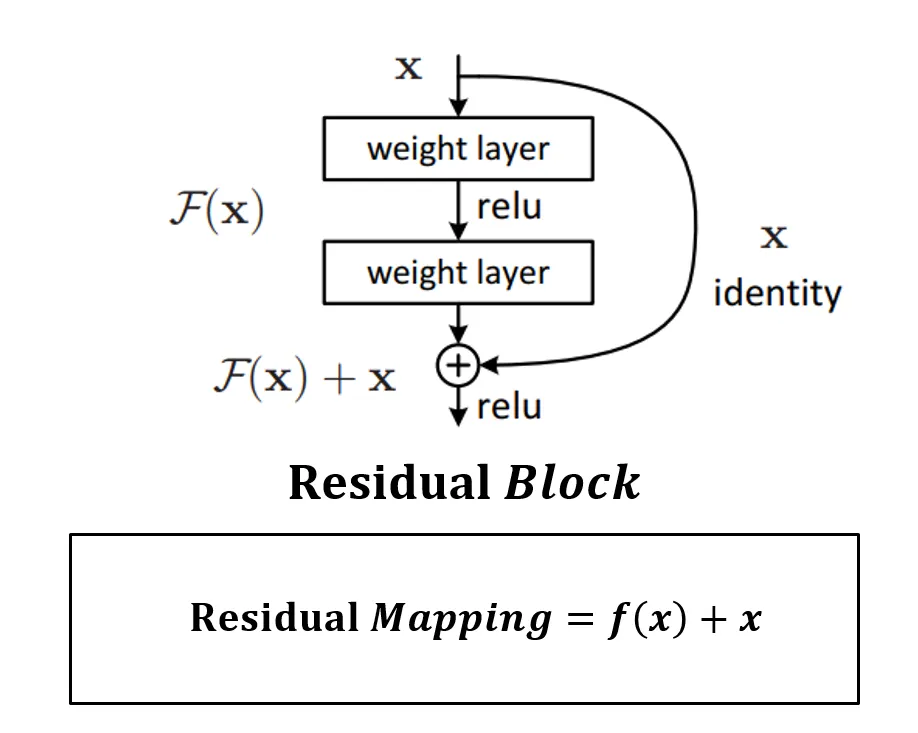

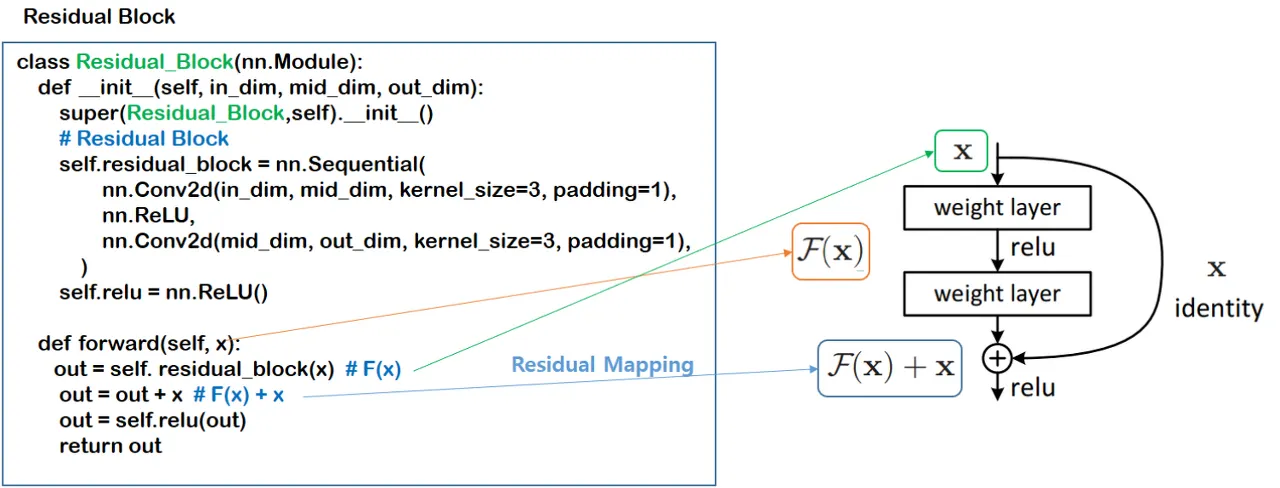

Residual Block

weight layer들을 통과한 F(x)와 weight layer들을 통과하지 않은 x의 합을 논문에서는 Residual Mapping 이라 하고, 위 그림의 구조를 Residual Block이라 하고, Residual Block이 쌓이면 Residual Network(ResNet)이라고 한다.